NVIDIA смогла в два раза ускорить исполнение языковых моделей на H100 с помощью TensorRT-LLM

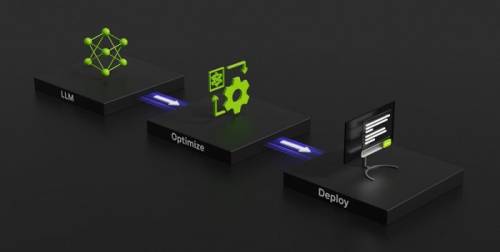

Компания NVIDIA официально анонсировала TensorRT-LLM — программное обеспечение с открытым исходным кодом, предназначенное для ускорения исполнения больших языковых моделей (LLM). Данная платформа будет запущена в течение ближайших нескольких недель.

Выполняя глобальную задачу по ускорению языковых моделей, компания NVIDIA сотрудничает с такими компаниями, как Meta*, Anyscale, Cohere, Deci, Grammarly, Mistral AI и другими. Библиотека представленной TensorRT-LLM призвана решить ключевую задачу — эффективное внедрение языковых моделей, не взирая на их огромные размеры и уникальные характеристики.

Новое программное обеспечение от NVIDIA включает в себя компилятор глубокого изучения TensorRT, оптимизированные ядра, инструменты для обработки, а также компоненты для повышения производительности на ускорителях NVIDIA. Причём, TensorRT-LLM позволяет в два раза ускорить производительность H100 в тесте GPT-J 6B, который входит в MLPerf Inference v 3.1.

Для управления нагрузками TensorRT-LLM использует специальный метод планирования — пакетную обработку в реальном времени, которая позволяет в асинхронном режиме обслуживать множество мелких запросов совместно с единичными большими на одном и том же ускорителе. Данная функция доступна для всех актуальных ускорителей NVIDIA. К слову, это именно она даёт двукратный прирост производительности инференса в случае H100.

* Внесена в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности».

#nvidia

Источник: overclockers.ru